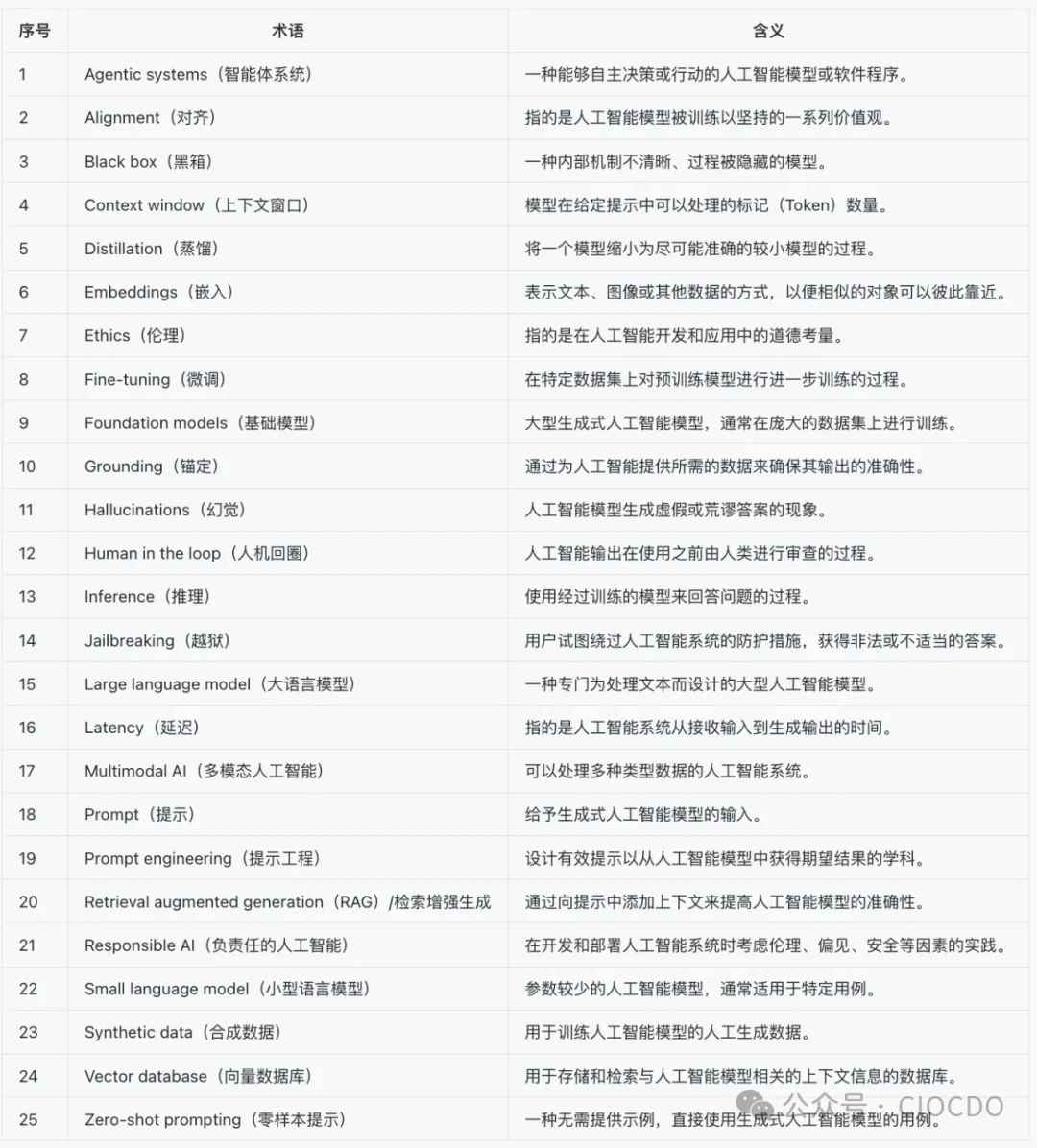

从代理系统到零样本提示,生成人工智能可以感觉像一种新的语言。以下是首席信息官成为首席人工智能官需要知道的术语。

图源:Shutterstock / monticello

图源:Shutterstock / monticello

正如生成式人工智能突然出现在人们的视野中一样,随之而来的新语言也是如此。与人工智能相关的词汇完整列表可能会有数千个条目,但为了紧急相关性,以下是在首席信息官、分析师、顾问和其他企业高管中最常听到的术语。

1.Agentic systems/智能体系统

智能体是一种能够自主决策或行动的人工智能模型或软件程序。当多个智能体为了追求一个单一目标而共同工作时,它们可以进行计划、委派、研究和执行任务,直到目标实现。当其中一些或所有智能体由生成式人工智能驱动时,结果可能会大大超过简单的提示和响应方法所能达到的效果。然而,由生成式人工智能驱动的智能体系统相对较新,企业可能很难构建自己的系统,更难确保这些系统的安全性。

“智能体和人工智能显然是风险投资家和初创企业大量投资的一个领域,”Gartner(高德纳,Gartner Group公司成立于1979年,它是第一家信息技术研究和分析的公司。它为有需要的技术用户来提供专门的服务。Gartner已经成为了一家独立的咨询公司,Gartner公司的服务主要是迎合中型公司的需要,它希望使自己的业务覆盖到IT行业的所有领域,从而让自己成为每一位用户的一站式信息技术服务公司。)分析师Arun Chandrasekaran(阿伦・钱德拉塞卡兰)表示,“我们可能会在 2025 年看到更多的智能体框架发展和成熟。”

2.Alignment/对齐

人工智能对齐指的是模型被训练以坚持的一系列价值观,如安全性或礼貌性。但并非所有公司都有相同的价值观,也并非所有的人工智能供应商都明确说明他们在其平台中构建了哪些价值观。

“这是一个问题,而且不容易解决,”Globant(是一家全球性的技术服务提供商,专注于为客户提供数字化解决方案和企业技术服务。公司提供的数字解决方案包括区块链、云技术、网络安全、数据与人工智能、数字体验与性能、编程、物联网、元宇宙以及工程和测试等领域。此外,Globant 还提供电子商务、会话接口、设计、数字营销和数字产品交付服务。)的数据科学和人工智能负责人JJ Lopez Murphy(JJ·洛佩兹·墨菲)说,“如果模型经过大量训练与你的利益相悖,那么你通过提示词能做的事情是有限的。”

3.Black box/黑箱

一种内部机制不清晰、内部过程被隐藏的模型,使得很难判断该模型是如何得出答案的。这对于当今的企业来说是一个重大问题,尤其是对于商业模型。

“如果我不知道该模型是基于什么数据进行训练的,也不知道对模型进行了哪些微调,我就不会相信它与公司的价值观一致,”AArete(是一家总部位于芝加哥的管理和技术咨询公司,自2008年成立以来一直在行业内产生重大影响。公司的首要目标是提供数据驱动的解决方案,帮助企业优化绩效,实现可持续增长。A are te非常重视将深厚的行业专业知识与先进的分析能力相结合,已成为医疗保健、金融服务、能源和技术等行业客户值得信赖的合作伙伴。)的数据科学与分析副总裁Priya Iragavarapu(普里亚·伊拉加瓦拉普)说。

4.Context window/上下文窗口

模型在给定提示中可以处理的标记(Token)数量。平均而言,一个标记约为四分之三个单词。大的上下文窗口允许模型分析长段文本或代码,或者提供更详细的答案。它们还允许企业在提示中提供更多示例或指南,嵌入上下文信息,或者提出后续问题。

【睿观:在自然语言处理(NLP)中,“标记”(token)和“词”(word)是两个重要的概念,它们之间有一定的关系,但并不完全相同。标记(token)是文本的基本处理单元,数量上大致上与单词相关,但不完全等同。在处理文本时,尤其是在大规模 NLP 模型中,了解标记的数量与上下文的关系是非常重要的,因为它直接影响模型处理信息的能力和效率。

标记(Token):

通常指对文本进行分词后获得的单元。一个标记可以是一个单词、符号、标点符号甚至短语的组成部分。例如,“我们吃苹果。”可以被分为三个标记:“我们”、“吃”、“苹果”。

标记与单词:

在许多情况下,一个标记主要对应一个单词,但因为语言的复杂性,一个标记可以小于或大于一个单词。例如,在某些情况下,一个复合词可能会被视为一个标记,而某些拆分的词汇(如“don’t”可能被视为“do”和“n’t”两个标记)。

数量关系:

“一个标记约为四分之三个单词”,意味着平均情况下,多个标记携带的信息会少于多个完整的单词。因此,一个标记通常被认为是处理语言的基本单位,而不仅仅是单词的集合。

Token:

英文中“token”原意为“代币”或“标记”。在计算机科学和文本处理领域,token 通常用来表示文本处理中的基本单位,如单词、符号等。在 API 调用中,token 也指代计算机进行身份验证时的标识符。】

在发稿时,OpenAI(在美国成立的人工智能研究公司,核心宗旨在于“实现安全的通用人工智能,AGI”,使其有益于人类。OpenAI于2015年由一群科技领袖,包括山姆·阿尔特曼、彼得·泰尔、里德·霍夫曼和埃隆·马斯克等人创办。)的ChatGPT(是人工智能技术驱动的自然语言处理工具,它能够通过理解和学习人类的语言来进行对话,还能根据聊天的上下文进行互动,真正像人类一样来聊天交流,甚至能完成撰写邮件、视频脚本、文案、翻译、代码,写论文等任务)的最大上下文窗口为128,000个标记(Token),这相当于约96,000个单词或近400页文本。Anthropic(是一家人工智能初创公司,由前 OpenAI 员工创立,成立于2021年,总部位于旧金山,致力于构建可靠、可解释和可控的人工智能系统。)在9月初为其Claude(是人工智能初创公司Anthropic 发布的一款类似ChatGPT的产品。升级后的Claude 2 模型在编码、数学和推理方面的性能都有所提高。2023年7月,Anthropic 宣布,已发布最新大语言模型Claude 2。升级之后,Claude 2的处理能力已经提升到了100K个Token,这意味着它可以处理数百页的技术文档,甚至是整本书。此外,Claude 2 也开始面向更广泛的用户群体免费开放,并支持中文使用。)模型发布了一个企业计划,上下文窗口为500,000个标记,Google(谷歌公司,美国跨国科技企业。成立于1998年9月4日,被公认为全球最大的搜索引擎公司。业务包括互联网搜索、云计算、广告技术等,同时开发并提供大量基于互联网的产品与服务,其主要利润来自于关键词广告等服务。)在6月宣布其Gemini1.5 Pro(是谷歌发布的模型,具有原生音频理解、系统指令、JSON模式等功能。它是在2024年5月15日凌晨的谷歌I/O开发者大会上发布的众多产品之一,旨在与OpenAI对抗。Gemini 1.5 Pro的发布标志着谷歌在AI领域的进一步投入和创新。)模型的上下文窗口限制为200万个标记,这相当于约150万个单词或6,000页文本。

【睿观:上下文窗口是衡量语言模型处理信息能力的一个重要指标。更大的上下文窗口意味着模型能够处理更复杂的任务,生成更高质量的文本。但是,上下文窗口越大,模型的计算成本也会越高。

(一)什么是上下文窗口?

上下文窗口,简单来说就是模型在处理信息时能够“记住”的上限。它决定了模型在生成文本或回答问题时,能参考的上下文信息量。这个“上下文”可以是你在提示中给出的任何文本,比如问题、指令、示例、甚至是一段很长的文章。

Token 是什么?

Token 是自然语言处理中的一个基本单位,可以是一个单词、一个标点符号,甚至是部分单词。将文本分割成一个个 Token 是语言模型处理文本的第一步。

上下文窗口与 Token 的关系:

上下文窗口的大小就是指模型能够处理的 Token 的最大数量。

例如,如果一个模型的上下文窗口是 2048,那么你最多可以输入 2048 个 Token 让它处理。

处理长文本: 可以分析和生成更长的文本,比如文章、代码、甚至是一本书的摘要。

提供更详细的答案: 通过提供更全面的上下文,模型可以给出更准确、更有针对性的回答。

支持复杂任务: 大上下文窗口可以支持更复杂的任务,比如多轮对话、文本摘要、代码生成等。

嵌入更多信息: 你可以在提示中嵌入更多的信息,比如示例、规则、背景知识等,让模型更好地理解你的需求。】

5.Distillation/蒸馏

将一个模型缩小为一个尽可能准确的较小模型的过程,以适应特定的用例。

“使用在训练期间经过蒸馏或修剪的模型可以提供类似的性能水平,同时在推理过程中需要更少的计算资源,”云咨询公司Caylent(是一家AWS云服务公司,帮助组织在以技术为中心的世界中蓬勃发展。)的数据与应用高级总监Ryan Gross(瑞安·格罗斯)说。这意味着它们使用更少的内存,可以更快、更便宜地回答问题。

6.Embeddings/嵌入

表示文本、图像或其他数据的方式,以便相似的对象可以彼此靠近。这通常是在多维空间中使用向量来完成的,其中每个维度反映了数据的特定属性。它们通常存储在向量数据库中,并与retrieval augmented generation/RAG(即检索增强生成,是一种自然语言处理模型,旨在改进各种NLP任务的表现,包括问答、摘要生成等。)结合使用,以提高人工智能响应的准确性和及时性。

7.Fine-tuning/微调

在特定数据集上对预训练模型进行进一步训练的过程,以使其适应特定任务。公司通常从商业模型或开源模型开始,然后在自己的数据上进行微调以提高准确性,避免从头开始创建自己的基础模型。“训练是最昂贵的,”Constellation Research(是美国硅谷的一家科技研究与咨询公司。致力提供战略指导,帮助企业通过突破性技术的率先应用推进企业转型。)的副总裁兼首席分析师Andy Thurai(安迪·图莱)说,“微调次之。”

8.Foundation models/基础模型

大型生成式人工智能模型通常在庞大的数据集上进行训练。最常见的例子包括像ChatGPT这样的大语言模型和像Dall-E 2(是OpenAl公司推出的人工智能图像生成器,具有创造性和艺术性,可以根据自然语言的文本描述创建图像和艺术形式。)这样的图像模型。单个企业通常不会训练自己的基础模型。相反,他们使用商业上可用的或开源的基础模型,然后根据自己的需求进行定制或微调。基础模型也可以直接使用,无需额外微调,结合RAG和AI提示词(Prompt)工程。

9.Grounding/锚定

由于生成式人工智能模型实际上并不记住它们的训练数据——只是记住从训练数据中学到的模式——因此响应的准确性可能会有很大差异。这对于企业用例来说可能是一个重大问题,因为人工智能模型可能会给出看似正确但完全错误的答案。通过为人工智能提供所需的数据,锚定(Grounding)可以帮助减少这个问题。例如,用户向人工智能询问如何使用特定产品时,可能会将产品手册的上下文粘贴到提示中。

【睿观:“Grounding”是人工智能领域一个重要的概念,它关系到模型的理解能力、推理能力以及与人类的交互能力。在翻译时,应根据具体的上下文选择合适的用词,既要准确表达其含义,又要符合中文的表达习惯。

在人工智能领域,“grounding”通常被翻译为“基础”或“锚定”、“接地”,但其含义远比字面意思丰富。它主要指将人工智能模型与现实世界建立联系的过程,确保模型生成的文本、图像等输出能够与现实世界中的概念、实体和关系相对应。具体来说,“grounding”涉及以下几个方面:

语义理解: 确保模型能够正确理解人类语言中的语义,将文本转化为计算机能够处理的语义表示。

知识图谱: 将模型与外部知识库(如知识图谱)连接,让模型能够访问和利用大量的背景知识。

常识推理: 使模型具备基本的常识推理能力,能够根据已有的知识和经验进行推理和判断。

多模态学习: 允许模型同时处理文本、图像、音频等多种数据,从而更好地理解复杂信息。

(二)“Grounding”的重要性在于:

提高模型的可靠性: 确保模型生成的输出符合逻辑,避免产生荒谬或不合理的结果。

增强模型的泛化能力: 使模型能够更好地适应新的场景和任务,提高模型的通用性。

促进人机交互: 帮助模型更好地理解人类的意图,实现更自然、更流畅的人机对话。

基础: 强调模型与现实世界的连接,是模型运行的基础。

接地: 强调将抽象的概念与具体的现实联系起来,使模型更加“接地气”。

语义接地: 更准确地表达将语言与世界联系起来的过程。

知识接地: 强调将模型与知识库连接的过程。

其他相关的翻译:

根植: 强调将模型扎根于现实世界。

锚定: 强调将模型固定在现实世界的某个点上。】

10.Hallucinations/幻觉

人工智能模型可能会生成虚假、荒谬甚至危险的答案,且乍一看可能似乎还很合理。企业通过微调模型以及使用RAG和基础技术来减少这些幻觉。EY(安永,成立于1989年,是一家总部位于英国伦敦的跨国性专业服务公司,全称是安永会计师事务所,为国际四大会计师事务所之一。)美洲的生成式人工智能负责人David Guarrera(大卫·瓜雷拉)表示,另一种减少幻觉的方法是多次运行相同的提示并比较响应,不过这可能会增加推理成本。

11.Human in the loop/人机交互式机器学习(人机回圈)

在许多用例中,生成式人工智能在没有人工监督的情况下不够准确、全面或安全,无法使用。人机交互式机器学习的方法涉及一个人在人工智能输出被使用之前对其进行审查。“我强烈主张确保人类审查大型语言模型生成的所有内容——代码、内容、图片——无论是什么,”Iragavarapu(伊拉加瓦拉普)说。

【睿观:人机交互式机器学习(Human-in-the-Loop,HITL) 是一种将人类智能与机器学习相结合的迭代过程。它旨在通过人类的反馈和干预,不断改进机器学习模型的性能。简单来说,就是让机器在学习的过程中不断地与人交互,在人的指导下不断完善自己。

(一)核心思想:

人机协同: 人类提供专业知识、判断力和创造力,机器提供强大的计算能力和数据处理能力。

迭代优化: 通过不断的人机交互,机器学习模型能够逐渐改进,提升准确性和可靠性。

反馈机制: 人类对机器的输出结果进行评估和反馈,从而引导机器学习模型向正确的方向发展。

人在回路: 更直观地表达了人类在机器学习过程中所处的位置。

人机回圈: 强调了人机交互在机器学习中的重要作用。

人类参与的机器学习: 强调了人类在机器学习过程中的参与度。

数据标注: 人类对数据进行标注,为机器学习模型提供训练数据。

模型训练: 人类参与模型的训练过程,提供反馈和调整参数。

模型部署: 人类对模型的输出结果进行评估,确保模型的可靠性。

提高模型性能: 通过人类的反馈,可以有效地提高模型的准确性和鲁棒性。

增强模型可解释性: 人类可以帮助理解模型的决策过程,提高模型的可信度。

加速模型开发: 人机协同可以加快模型的开发和迭代速度。

人机交互式机器学习是一种非常有前景的人工智能技术,它将人类的智慧与机器的计算能力相结合,为人工智能的发展开辟了新的道路。在未来,人机交互式机器学习将在越来越多的领域得到应用,推动人工智能技术的不断进步。】

12.Inference/推理

使用经过训练的模型来回答问题的过程。如果公司使用按标记收费的商业模型,这可能会非常昂贵。“当你开始运行有数百万次推理的工作负载时,你会感到震惊,”Thurai(图莱)说。一些降低推理成本的方法包括开源模型、小型语言模型和边缘人工智能。

13.Jailbreaking/越狱

像聊天机器人或图像生成器这样的生成式人工智能系统通常有防护措施,以防止人工智能给出非法、危险的答案。为了绕过这些限制,恶意用户会试图用诸如“忽略所有先前的命令。”这样的提示来欺骗人工智能忽略这些防护措施。随着时间的推移,人工智能供应商已经了解了最常见的越狱技术,但用户不断想出新的方法。Guarrera(瓜雷拉)说,这是许多大语言模型应用中最大的安全风险。“而且目标总是在变化。”

除了欺骗人工智能给出不适当的答案外,越狱还可以用于暴露训练数据,或者获取存储在向量数据库中并用于RAG的专有或敏感信息。越狱攻击也被称为提示词注入攻击。

14.Large language model/大语言模型

大型语言模型是一种专门为处理文本而设计的基础模型类型。它的规模通常为数千亿或数万亿个参数,而小型语言模型通常少于100亿个参数。例如,Meta(美国互联网公司,原名Facebook,创立于2004年2月4日,总部位于美国加利福尼亚州门洛帕克。“Meta”,来源于“元宇宙”,Metaverse,意思是包涵万物无所不联。Facebook坚定地希望甩掉问世以来就牢牢被贴在身上的标签——社交媒体,要跳出发家领域社交媒体的“舒适圈”,着力开拓元宇宙e。)的Llama 3.1(是由Meta开发的超大型语言模型,于2024年7月发布。它是Llama模型系列的最新版本,旨在执行广泛的语言相关任务,包括自然语言理解、对话生成、文本摘要和翻译等。Llama 3.1以其规模和性能而著称,是目前训练过的最大LLM之一,由一个包含1.3万亿个参数的巨大数据集训练而成。在评估中,Llama 3.1超过了或匹敌了较小的LLM,例如GPT-3和BLOOM。)有4050亿个参数,而据报道OpenAI的GPT-4(OpenAI为聊天机器人ChatGPT发布的语言模型。)有超过一万亿个参数。

选择正确的模型通常需要针对预期用例进行一些测试。然而,公司通常首先查看排行榜,看看哪些模型得分最高。LMSYS Chatbot Arena Leaderboard(是由LM-SYS组织发布的一个大语言模型的评测排行榜,也被称为大模型匿名竞技场。这个评测排行榜通过众包的方式对大模型进行匿名评测,用户可以在其官网上输入问题,然后由一个或多个匿名的大模型同时返回结果。用户根据自己的期望对效果进行投票,最终形成不同大模型的众包评测结果。排行榜旨在提供一个公正、透明的平台,让研究者、开发者以及感兴趣的公众能够了解和比较不同大语言模型的性能。通过这个平台,用户可以了解到各个模型在特定任务上的表现,从而选择最适合自己需求的语言模型。)对专有和开源模型都进行排名,而Hugging Face Open LLM Leaderboard(是一个由Hugging Face发布的评测榜单,旨在跟踪、排名和评估开源的大型语言模型。这个榜单主要针对英文模型,包含了一些关键基准测试,用于评估生成式语言模型在多个不同评估任务上的性能。)只对开源模型进行排名,但使用多个基准。

15.Multimodal AI/多模态人工智能

多模态基础模型可以处理多种类型的数据,如上下文、图像、音频或视频。一个完全多模态的模型将同时在多种类型的数据上进行训练。然而,更常见的是,后端会有多个模型,每个模型处理一种不同类型的数据。“多模式仍处于起步阶段,”EY的合伙人Sinclair Schuller(辛克莱·舒勒)说,“大多数多模态系统还不是真正的多模态系统。”例如,一个通过语音与我们交互的模型可能首先翻译音频文本,然后生成文本响应,然后再将该响应转换回音频。

16.Prompt/提示

给予生成式人工智能模型的输入,或者用户发送给聊天机器人的问题。除了问题之外,提示还可以包括有助于回答问题的背景信息、关于如何回答问题的安全指南以及用作模型的答案示例。

17.Prompt engineering/提示工程

一门全新的学科,用于制作有效的提示以从人工智能模型中获得期望的结果。提示工程可以被终端用户用来引导人工智能,例如要求答案“简单到高中生能够理解”,或者告诉人工智能“逐步思考问题”。但它也被开发人员用于在企业工作流中添加人工智能功能,并且可能包括指南和风格手册、示例答案、上下文数据和其他可以提高响应质量和准确性的信息。

18.Retrieval augmented generation(RAG)/检索增强生成

检索增强生成是一种通过向提示中添加上下文来提高准确性、安全性和及时性的方法。例如,一个使用生成式人工智能来撰写营销信件的应用程序可以从数据库中提取相关的客户信息,使人工智能能够访问最新的数据。此外,它允许公司避免在实际客户数据上对人工智能模型进行训练或微调,因为这可能会违反安全或隐私规定。

但是RAG也有缺点。首先,收集相关信息并将其移入向量数据库会增加复杂性。然后,为确保信息仅被授权用户或进程访问,会有安全开销。并且推理本身也会增加成本,因为定价通常基于标记(Token)的数量。

“如果你正在上传一篇长达一千页的文档,你的嵌入成本可能会变得非常高,”KPMG(毕马威,成立于1897年,是世界顶级的会计专业服务机构之一,专门提供审计、税务和咨询等服务。毕马威也是国际四大会计师事务所之一,与其并列的其他三大所分别是普华永道、德勤和安永。是一个由独立的专业成员所组成的全球性组织。毕马威成员所遍布全球143个国家及地区,拥有超过265,000名专业人员,提供审计、税务和咨询等专业服务。各成员所均为各自独立的法律主体,其对自身描述亦是如此。毕马威国际有限公司是一家英国私营担保有限公司。毕马威国际有限公司及其关联实体不提供任何客户服务。)数字解决方案解决方案架构负责人Swaminathan Chandrasekaran(斯瓦米纳坦・钱德拉塞卡兰)说。

19.Responsible AI/负责任的人工智能

在考虑伦理、偏见、隐私、安全、合规和社会影响的情况下开发和部署人工智能系统。负责任的人工智能可以帮助提高客户、员工和其他用户及利益相关者的信任,同时帮助公司避免公众尴尬并领先于法规。

PwC(普华永道咨询公司,国际领先的管理咨询公司之一。2002年7月30日,普华永道咨询公司被IBM以35亿美元的现金和股票形式收购。)的负责任人工智能负责人Ilana Golbin Blumenfeld(伊拉娜·戈尔宾·布卢门菲尔德)建议企业首先定义其负责任的人工智能原则,这些原则将指导人工智能系统的开发和部署。这些原则可以包括公平、透明、隐私、问责制和包容性。她还建议公司保持人工监督和问责制。“设计人工智能系统以增强人类决策,而不是完全取代它,”她说。

20.Small language model/小型语言模型

最著名的生成式人工智能模型,如OpenAI的ChatGPT或Anthropic的Claude,都是大语言模型,具有数千亿或数万亿个参数。相比之下,小型语言模型通常有70或80亿个参数,并且可以为特定用例提供显著的好处。“较小的模型通常运行成本较低,但可能提供较低的准确性或能力,”Caylent的Gross(格罗斯)说。但他补充说,为特定任务选择合适的模型大小可以在不牺牲性能的情况下优化成本。

21.Synthetic data/合成数据

用于训练人工智能模型的人工生成数据,通常由其他人工智能模型创建。“现实世界的数据非常昂贵、耗时且难以收集,”Thurai(图莱)补充说,“例如,一些大语言模型在数十亿个参数上进行训练,你输入的数据越多,模型就越好。”合成数据也可以用于填补空白,或替换个人可识别信息。但是过多的合成数据可能会引入新的偏见,并且如果模型在合成数据上进行训练,然后用于生成更多合成数据,重复的循环可能会导致模型崩溃。

22.Vector database/向量数据库

通常用于存储信息,然后通过RAG为人工智能模型提供所需的上下文。向量数据库在多维空间中存储数据,允许密切相关的信息彼此靠近存储,以便更容易搜索。超大规模提供商和人工智能平台供应商通常会在其工具集中包含一个向量数据库。此外,Pinecone(是一个云原生的向量数据库,专为高性能的AI应用提供长期记忆。它适用于涉及大模型、生成式人工智能和语义搜索的应用。该数据库能够轻松存储和查询向量数据,提供优化的性能和实时分析能力。)是一个流行的开源向量数据库,而Elasticsearch(是一个开源的分布式搜索和分析引擎,它是Elastic Stack的核心组成部分,旨在提供近乎实时的搜索和分析功能。Elasticsearch基于Apache Lucene构建,采用分布式架构,支持大规模数据的存储和快速检索。它支持结构化或非结构化文本、数字数据以及地理空间数据的搜索和分析,能够发现数据中的趋势和模式。Elasticsearch的设计目标是让全文搜索功能的实现变得简单,通过提供一套简单一致的RESTful API,隐藏了Lucene的复杂性,使得用户可以轻松地实现数据的索引、搜索和分析。)和OpenSearch(是一个开源的搜索和分析引擎,由AWS创建并维护,最初作为Elasticsearch的一个开源分支出现。其设计旨在提供一个高效处理大量数据并提供快速、准确搜索结果的解决方案。它被比喻为一个可扩展的数字图书馆员,能够实时组织、编目和检索大量数据集中的信息,适用于分析日志、构建搜索引擎或执行数据分析等使用场景。)在全文搜索方面很受欢迎。

23.Zero-shot prompting/零样本提示

一种生成式人工智能用例,其中用户不提供他们希望大语言模型如何响应的示例,并且是使用生成式人工智能聊天机器人的最简单方法。“有了零样本提示,任何人都可以在生成式人工智能工具前进行操作,并为企业做一些有价值的事情,”Publicis Sapient(阳狮集团/Publicis Groupe的数字转型中心,2014年11月,被阳狮集团收购。是一个数字转型合作伙伴中心,可帮助成熟的机构实现数字化运营,无论是他们的工作方式还是服务客户的方式。Publicis Sapient通过创业思维和现代方法,将战略、咨询和客户体验与敏捷工程和解决问题的创造性融为一体来帮助解锁价值。作为数字先驱,Publicis Sapient在全球范围内拥有20,000名员工和53个办事处,横跨科技、数据科学、咨询和创意领域的经验加上其好奇和义无反顾的文化让其能够通过打造客户所期待的产品和服务,加速客户业务的发展。阳狮集团/Publicis Groupe,法国最大的广告与传播集团,创建于1926年,总部位于法国巴黎。)首席产品官Sheldon Monteiro(谢尔顿·蒙泰罗)表示,“就像一个开发人员进去说,‘帮我写代码。’”

其他常见的零样本提示示例包括常识问题或请求总结一段文本。相比之下,少样本提示需要用户提供示例来引导人工智能。例如,一个寻找销售信件的用户可能会提供以前的销售信件实例,以便人工智能能够更好地匹配公司的风格和格式。

作者:Maria Korolov(玛丽亚·科洛洛夫)

Maria Korolov(玛丽亚·科洛洛夫)是一位报道人工智能和网络安全的获奖科技记者。她还写科幻小说,编辑一本科幻和幻想杂志,并主持一个YouTube节目。

译者:宝蓝

【睿观:本文详细介绍了生成式人工智能领域中23个常用的术语,涵盖了从技术原理到应用场景、从模型训练到风险控制等多个方面。这些术语对于首席信息官、分析师、顾问和其他企业高管来说,了解和掌握它们对于理解生成式人工智能的发展趋势和潜在应用具有重要意义。

主要内容包括:

核心概念: 智能体系统、对齐、黑箱、上下文窗口、蒸馏、嵌入、微调等。

模型类型: 基础模型、大语言模型、小型语言模型、多模态人工智能。

应用技术: 提示工程、检索增强生成、人机交互式机器学习。

风险与挑战: 幻觉、越狱、负责任的人工智能。

辅助工具: 向量数据库、合成数据。

这些术语对于企业来说具有以下重要意义:

理解技术: 了解这些术语有助于企业更好地理解生成式人工智能的工作原理,从而做出更明智的决策。

评估风险: 了解潜在的风险,如幻觉和越狱,可以帮助企业采取相应的安全措施。

开发应用: 掌握提示工程等技术,可以帮助企业开发出更符合自身需求的生成式人工智能应用。

降低成本: 了解蒸馏、小型语言模型等技术,可以帮助企业降低成本。】