编辑|胡润峰

本文首发于钛媒体APP

AI视频模型赛道近期已成为生成式AI领域新风口,最新发布的是“字节版Sora”。

9月24日,预告已久的2024火山引擎AI创新巡展深圳站上,字节跳动首款AI视频模型——豆包·视频生成模型正式登场。

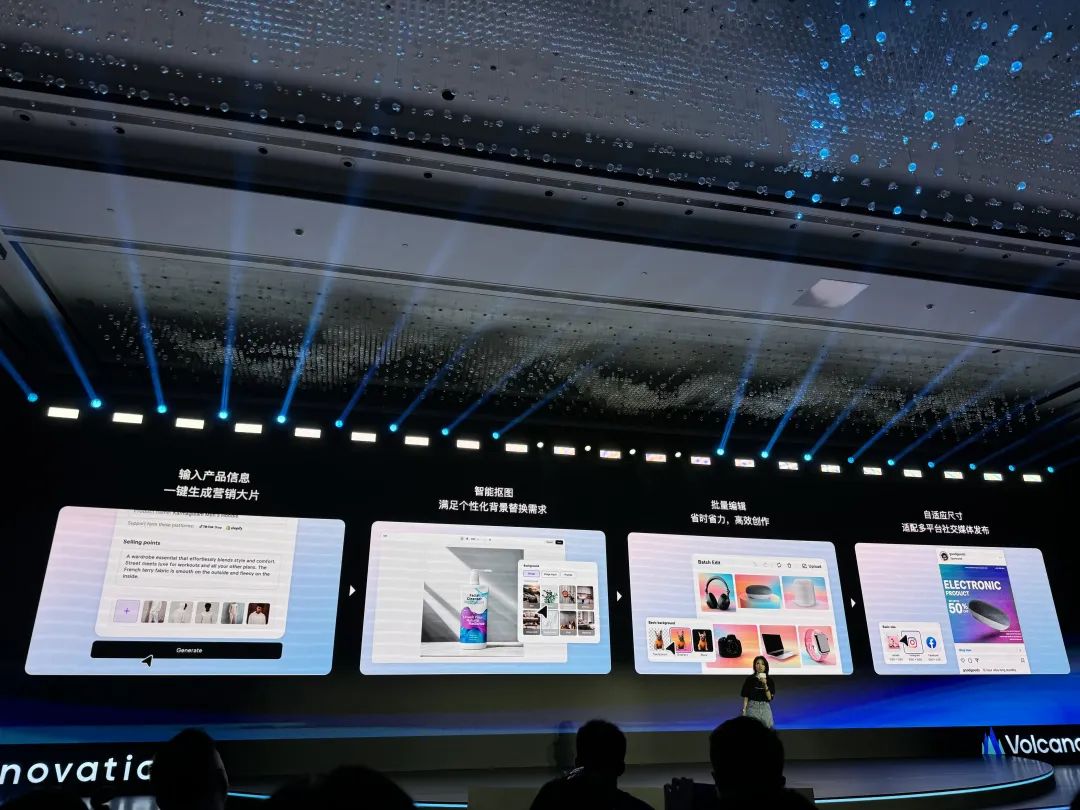

豆包·视频生成模型基于全新DiT扩散模型架构,能够精准理解复杂prompt(提示词),实现多个主体运动的复杂交互,保持多镜头切换内容的一致性,且具备高保真高美感的影视级生成水准,从而用于电商营销、城市文旅、动画教育、微短剧等多个场景中。

那么,不仅“纸上谈兵”,而且还要“真练”,那么我们下面看看“字节版Sora”效果如何。

首先是一段“童话王国”视频,花团锦簇在小房子周围,门窗和灯光清晰可见,桥上和房子背后的动物动作栩栩如生。

第二段是羊群奔跑的状态,腿部和奔跑状态都如同真实场景一般,后面的黑羊穿过乌云跑向前方。

最后一组是呈现多尺寸高清视频,以及展现AI生成“口红”广告的品牌营销,基于豆包·视频生成模型,鲜红色的口红能让更多人有了下单购买的欲望。

而且,豆包大模型时隔不到半年还实现6款模型发布和能力升级,包括:豆包·视频生成模型、豆包·同声传译模型、豆包·音乐模型;以及升级的豆包通用模型pro、豆包·语音合成模型、豆包·文生图模型。

很显然,火山引擎正加速豆包大模型产品和方案落地。

实际上,当下大模型技术快速迭代,技术可用性大幅提升,已具备文本、语音、视觉的多种模态能力,并开始完成复杂指令。因此,生成式AI技术竞赛已进入“下半场”,不仅要有能力,而且商业化也成为各家AI公司的“必争之地”。

《生成式AI商业落地白皮书》显示,当前有53%的中国企业已开始有组织地进行生成式AI布局。这意味着,很多中国企业已意识到生成式AI技术对于自身发展的重要性,并将在其中投入资源和精力。

一个公开数据可以例证:今年上半年,国内AI相关招投标市场招标总额已超过2023年全年规模,用于教育、医疗、交通等多个领域的数百个场景。

作为中国领先的云和智能解决方案企业,火山引擎最新数据显示,截至今年9月,豆包大模型的日均Tokens使用量已经超过1.3万亿,4个月时间里Tokens整体增长超过10倍;同时,C端下载量超过1亿次,拥有超过3000万月活,经过字节跳动内部50+真实业务场景实践验证,30+行业外部企业深度共创。

“(今年)下半年是整个AI应用的元年。”火山引擎总裁谭待表示,作为国内第一个把模型成本做到每千token低于一厘钱的企业,火山引擎的豆包大模型推动大量的创新应用随之不断涌现,模型调用量突飞猛进,大家共同努力让应用的生态更加繁荣。

如果说2023年还是“百模大战”,大家卷技术、卷能力。而到了今年,以火山引擎为代表的“中国OpenAI”们,不仅在大模型层面要有强大“能力”,同时也需要实现对客户的快速交付及商业落地,证明着生成式AI技术能够对企业产生更大的业务价值、产业价值。

三大豆包垂直模型首发

主力模型综合提升超25%

2024年,全球生成式AI技术持续“狂飙”。

Crunchbase数据显示,2024年上半年,全球AI风投总投资规模达330亿美元,比2023年同期增长177%。预计今年全年,全球AI投资规模将有望达到650亿美元,在这其中,被投企业主要来自AI基础设施和AI应用领域。

年初至今,OpenAI发布的三款AI大模型产品,包括2月的AI视频模型Sora、5月的实时通话模型GPT-4o、9月的推理最强模型o1-preview和o1-mini持续引发关注。

回到国内,“百模大战”正转向百款AI应用和场景模型,并呈现新一轮“百家争鸣”竞争态势。字节跳动、阿里、腾讯、百度、蚂蚁、智谱AI等企业纷纷发力,文小言、支小宝、秘塔AI搜索等多款AI智能体(Agent)应用不断落地。

截至目前,作为国内使用量最大、应用场景最丰富的大模型服务商之一,火山引擎已经公布超过10款AI模型。同时,智源研究院旗下FlagEval大模型评测平台此前发布的榜单显示,在闭源大模型的“客观评测”中,豆包大模型以综合评分75.96分排名国产大模型第一。

如今,火山引擎再度发力。9月24日,火山引擎AI创新巡展深圳站上共发布和升级6款大模型产品:

3款全新发布:豆包·视频生成模型、豆包·同声传译模型、豆包·音乐模型;

3款模型能力重磅升级:豆包通用模型pro、豆包·语音合成模型、豆包·文生图模型。

首先是非常受关注的豆包·视频生成模型,堪称“字节版Sora”。

全新豆包·视频生成模型基于DiT架构,通过自研的高压缩比、高还原性视频隐状态编码和解码模型,强力保证了扩散模型在隐状态空间的高效编码与运转。而豆包·视频生成模型基于深度优化的Transformer结构,从而大幅提升视频生成的泛化能力。

事实上,文生视频作为新的AI视频制作工具,当前主要解决4个方面的问题:提高效率、降低成本、创意实现、版权合规。

全新豆包·视频生成模型具备诸多卓越特性:精准的语义理解能力可处理高难度 prompt(提示词),达成时序性多拍动作与多主体复杂交互;切镜方面,全新的扩散模型训练方法攻克了多镜头切换一致性难题,10秒就能讲述一个起承转合的故事且各镜头主体、风格等保持一致,支持一致性多镜头生成;借助高效的DiT融合计算单元,它能呈现强大的动态与丰富的运镜效果,其影视级的生成水准,细节逼真、美感十足,还支持多种风格和比例,能快速生成优质的视频片段,赋能电商影视创作、广告传媒、短视频等多个场景。

例如,电商营销行业,文生视频可以把商品变成3D动态多角度展示视频,匹配适合的营销背景素材(中秋、春节、七夕等)并生成不同尺寸快速上架;动画教育行业,文生视频可以降低动画的制作成本,低门槛的实现童话故事的想象情景等超现实画面。

这是一段香水广告,透过豆包·视频生成模型,可以展现水流淌到香水周围的画面,凸显香水的高贵与典雅。

其次是直接对标Suno的豆包·音乐模型——你的专属“音乐创作大师”。

该音乐模型可以通过“海绵音乐”进行体验,用户只需通过简单的描述或上传一张图片,就能轻松生成一首包含旋律、歌词和演唱的1分钟高品质音乐作品,并支持民谣、流行、摇滚等10余种不同的风格和情绪的随心选,极大地简化了音乐的创作过程,可应用于音乐创作、音乐教育、娱乐产业、广告营销等应用场景。目前,豆包·音乐模型已经上线“海绵音乐”App和网页平台,而且也可以在“豆包”产品内进行体验。

下图是我们利用一段情感类文字,几秒钟就生成了1分钟左右的高品质音乐,你可以听一下效果。

再次是全新的豆包·同声传译模型。

该模型基于端到端同声传译智能体CLASI,效果已接近专业人工水平的同声传译。依托于豆包基座大模型和豆包大模型语音组的语音理解能力,具备实时翻译、超低延时、自然高质量、音色克隆等特点。同时,在办公、法律、教育等场景中,豆包·同声传译模型显著超过了其他所有竞品,并且在两个语向上均达到78%以上的准确性,接近甚至超越人类同传水平,并具备了从外部获取知识的能力,形成媲美人类水平的同声传译系统。

最后是豆包通用模型pro、豆包·语音合成模型、豆包·文生图模型实现能力升级。

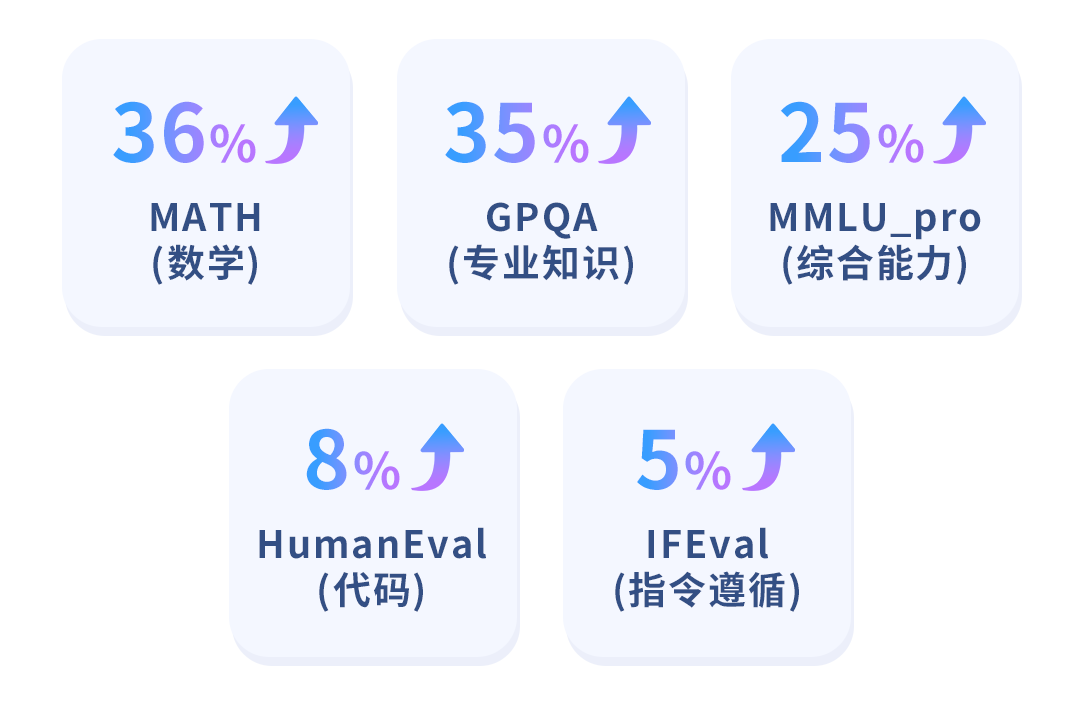

其中,作为豆包主力模型,此次豆包通用模型Pro的最新模型在数学能力、专业知识方面有超过35%的提升,综合能力超过25%的提升,其他包括指令遵循、代码等能力也在持续提升,能够面对复杂的企业生产场景。同时,Pro具有长文本能力,上下文窗口长度翻至两倍,达到256K,约40万汉字。

同时,豆包·文生图模型全面升级到2.0,采用更高效的DiT架构,能显著提升模型的推理效率和整体性能,在复杂图文匹配、极速模型出图、中国文化理解都有提升。基于高效DiT构架,同等参数下推理消耗是flux的67%,模型最快做到3秒出图同时,在内部Elo数十万轮评测第一名。据披露,自豆包文生图模型在豆包App上线以来,人均下载图片数量提升1倍,下载用户人数提升45%。

比如,这张戴着棒球帽、墨镜并喝着咖啡的卡通风格插图。

基于全新豆包·文生图模型,可以实现复杂图文匹配,精确呈现真实世界与想象世界的复杂场景,包括更符合物理世界规律现实场景,升级多数量、多属性、大小、高矮、胖瘦和运动6类图文生成难点的精准匹配,并更好实现对中国古代绘画艺术的理解和呈现。

此外,豆包·语音合成模型能力也全面升级,一句话声音复刻后就能混音创作,支持超强混音功能,打破语音合成的音色数量限制,并能够精准捕捉不同声音的韵律、音色、表达方式、语气语调等特色,而且可以将数百种精品音色自由组合,无限DIY不同音色、情感、性别、年龄和风格的声音,创造出极具戏剧张力的语音效果,在连贯性、音质、韵律、气口等各方面表现堪比真人。

总结来看,截至目前,从文字到语音合成,从文生图到视频生成,豆包大模型都已全部覆盖,不仅拥有更强模型能力,而且有更低价格、更易落地等特点,利用AI和云帮助企业和客户能够解决一系列实际问题。

谭待表示,任何数字化底座一定是云,包括现在AI也是数字化的一部分,基于AI的云设施可以给客户传递更大价值。企业要做好大模型落地,面临模型效果不好、成本太贵、落地太难三大关键挑战,因此,火山引擎既要有好的基础大模型做支撑,解决复杂难题,也要有低成本的推理服务让大模型被广泛应用,还要更多工具、平台和应用帮助企业做好场景落地。

加速商业落地

共创关键场景应用

今年上半年,AI大模型“价格战”又引爆了行业竞争。

截至目前,在各家大模型最强版本价格对比中豆包大模型比行业价格低98%以上。

以豆包为核心的国内AI大模型将价格逼近“厘时代”。而这种极低的成本,使得大模型商业化应用变得更加可行,不仅对大型企业有利,而且为中小企业提供了前所未有的机会。

从“参数战”到“价格战”,AI大模型领域正由技术之争,转变为商业之争。这不仅是成本与市场的博弈,也更加考验企业的创新能力、应用能力、运营和商业化能力。公开调研数据显示,有37%的受访企业认为,基于生成式AI技术可以给项目带来超过10%的成本缩减。

对于中国超过5200万中小微企业来说,尽快落地生成式AI技术至关重要。当前AI时代,企业面临诸多挑战,降本增效是生存关键,且需数字化、智能化转型升级,不断创新,以免错失机遇。在科技快速发展的今天,未及时跟进的企业可能会在未来竞争中处劣势。

作为国内云与智能服务商,基于豆包大模型更强模型、更易落地、更低价格特点,火山引擎已经宣布与30+行业外部企业深度共创豆包大模型商业落地,全面助力零售、游戏、汽车、教育、医疗、企业服务等领域,助力客户提速增效。

以企业物流领域龙头G7易流为例。

当前随着直播电商和外卖物流需求快速增长,国内快递包裹数量高达1150亿件以上,因此,物流领域面临预订单和订单的管理问题。然而,不同系统、平台和通信渠道(如微信群)中的订单单据格式千差万别,这给物流行业的录单工作带来了极大的挑战。传统的人工录单方式需要将原始的、非结构化的信息转化为格式化数据,这一过程不仅工作量大、效率低下,而且容易出错。

因此,G7易流利用豆包大模型的强大语言理解和文字抽取能力,联合豆包大模型打造“智能接单”机器人,可迅速从微信群中提取关键信息如客户名称、货物详情、发车时间等,并将其转化为结构化数据直接导入业务系统,进一步显著提高接单的效率和准确性,使录单工作变得异常便利。

其中,处理能力层面,大模型简化了G7易流平台数据处理流程,大幅缩短接单时间,产品日均处理量稳定在300-400单之间,接单时间从原2小时减至30分钟以内,效率提升高达75%,提升了整体业务效率。而且,通过精确的数据处理,显著提高订单的准确性,进而提升客户满意度。

2024 ITValue Summit数字价值年会上,G7易流创始人、首席执行官翟学魂提到,“如果我们能够在窘迫的产业中,发现可以改变产业结构的稀缺的数据,并让这些数据形成闭环,产生飞轮效应,我们就有可能获得‘一线生机’。”

G7易流首席科学家王守崑则认为,事实证明,结合大模型技术,确实能够提升我们平台的接单效率。G7易流和火山引擎是一次成功的尝试,也是技术与物流行业的创新结合,我们对未来更多更深入的合作充满期待。

除了物流行业,客服、销售这一领域也是大模型能够快速落地以及产生价值的重要场景。

专注智能客服10余年的晓多科技选择与火山引擎合作,基于豆包大模型,晓多科技全面升级智能客服能力。结果显示,在火山引擎提供的豆包大模型帮助下,晓多科技的“AI训练场”场景获得了更高的并发保障,同时成本也优化了50倍以上,实现了效率成本双提升。通过使用豆包大模型能力强化的“AI训练场”,晓多科技不仅将客服培训周期缩短了50%以上,还通过更多元化的顾客模拟,训练出能力超越常规培训的客服团队,推动销售转化率上升了3%-5%。

很显然,豆包大模型以创新技术驱动的极致性价比,助力G7易流、晓多科技在业务当中提质增效,实现了效率成本双升级,从而为火山引擎在物流、智能客服、零售等行业性整体落地和开拓商业模式打下了坚实的基础。

谭待强调,火山引擎的定位是云和AI服务提供商,在大模型的时代,他们的主要目标是帮助企业降低成本、提高效率,并且促进企业的创新。在生成式AI的时代,找到产品市场匹配度(PMF)是至关重要的。这需要厂商不仅要对技术有深入的了解,还要对业务有透彻的认识,这样才能确保技术能够真正落地并发挥作用,进而构建起火山引擎的AI生态系统。

大模型落地非一蹴而就

火山引擎与产业共创新AI时代

中国以大模型为核心的生成式AI竞争已进入“下半场”,商业落地成为关键,尤其AI已逐步给企业带来直接的成本节约或效率提升。可以预见,“价格战”的下半场将是“商业战”、“生态战”。

不过,当前OpenAI的商业化之路不如预期,导致市场对AI产生了更多的质疑。

据报道,2023年OpenAI年收入达到34亿美元左右,但包括租用微软服务器(40亿美元)、招聘大量顶尖人才(15 亿美元)在内,OpenAI运营成本却可能高达85亿美元,即OpenAI每年或亏损高达50亿美元。而如其他商汤、云从在内的AI软件公司,也依然面临持续亏损、盈利能力较弱等风险。

而相对于OpenAI面临的商业挑战,火山引擎依托字节跳动强大的算法、算力、数据和商业化经验能力,在豆包大模型层面拥有更清晰的研发路径、商业化路径,基于丰富的端到端、垂类、场景化豆包大模型,火山方舟等一系列解决方案,火山引擎将技术能力优势和行业落地相结合,不仅发力B端市场,而且在C端市场上也有更多的商业想象空间,持续释放其价值潜力,正成为各行各业落地实践的更优选。

未来,生成式AI将开启一个新的黄金时代,拥有巨大的市场潜力。

据研究机构IDC预测,到2030年,AI将为全球经济贡献19.9万亿美元,推动2030年全球GDP增长3.5%。这意味着,AI是全球经济增长的新引擎。

当前,围绕AI能力的新应用和服务将不断涌现,在各个行业掀起智能化变革的浪潮。从金融、医疗、教育到制造、交通、能源等领域,AI技术都将找到广阔的应用空间,为传统行业注入新的活力。

面对新一轮生成式AI革命,企业需要以开放、创新的心态拥抱变革。而从文生图的DiT架构升级,到语音模型的“All-in-One”,火山引擎将持续提供强大AI模型、云计算等技术优势和能力,有志于“用科技改变世界”,以更强模型、更低价格、更易落地方式助力企业成长,推动各行各业在AI变革中抓住先机,重塑现有的行业格局和价值链。

当AI技术变得无处不在、无所不能时,它将像互联网一样,深度融入商业和社会的方方面面,就像今天的互联网一样渗透到每个角落,成为支撑一切活动的基础设施,推动中国经济持续产生新动能。

(本文首发于钛媒体App)